Tipps und Tricks

Anwenderwissen

Farb-CMOS Sensor

Das normale Umgebungslicht im Büro oder in einer

Fertigungshalle reicht fast bei den meisten monochromen

Video-Hochgeschwindigkeitskamerasystemen noch. Sie zeigen

Empfindlichkeiten irgendwo zwischen einigen hundert und einigen

tausend ASA bei nominaler Aufnahmefrequenz, abhängig von der

Verstärkung. Farbversionen zeigen gewöhnlich nur ca. 25%

davon.

Die Besonderheiten gegenüber üblichen Aufnahmen entstehen

hauptsächlich durch die i.d.R. kurzen Belichtungszeiten und das

Arbeiten am Limit - physikalisch wie technisch.

Ansonsten gelten natürlich die üblichen fotografischen Regeln,

Beschränkungen und selbstverständlich Möglichkeiten.

Aufnahmetipps

Beleuchtung, Blende und Dynamik

Doch es gilt: Viel hilft viel. Je mehr Licht zur

Verfügung steht, desto weiter kann man die Blende schließen, d.h.

eine höhere Blendenzahl einstellen, und damit die Schärfentiefe

verbessern. Ab Blende 8 ist es ganz in Ordnung, aber 5,6 reicht

auch schon.

Zu viel Licht gibt es eigentlich nie - man kann durchaus die

glühende Wolframwendel eines 500 W Halogenstrahlers, eine

Laserschweißung oder eine elektrische Entladung aufnehmen.

(Vorsicht: direkt in den Laser zu schauen ist dann aber doch zu viel.)

Problematisch ist nur die Helligkeitsdynamik der Kamera. Das gilt

eigentlich für alle elektronischen Kameras. Schön kann man das an

einer Aufnahme aus der Tiefe eines Raumes hinaus durchs Fenster

sehen. (Deswegen sind bei Interviews in Büroräumen auch gerne die

Vorhänge zugezogen oder die Jalousien geschlossen. Außerdem spiegeln

sich dann auch die Scheinwerfer nicht so. Bis HDRI (High Dynamic

Range Image) groß Einzug hält, wird es wohl

noch dauern.) Die üblichen 8 bis 12 bit bzw. 256 bis 2 048

Helligkeitsstufen sollten möglichst gut

ausgenutzt werden, auch wenn schon 64 Graustufen (6 bit) einen

ausreichenden Bildeindruck hinterlassen. Will man die weniger hell

erleuchtete Umgebung noch sehen, muss man sie entsprechend

ausleuchten. Vergleichbar dem Füllblitz bei der Fotografie.

Übrigens, falls es doch einmal zu hell sein sollte, sorgen

Graufilter (neutral density, kurz: ND; dt.: neutral, ohne

Farbstich) für Abhilfe. Oder selektive Filter, die z.B. die

Wellenlänge eines Schweißlasers ausblenden, nicht aber die des

Schweißguts. Viele Objektive besitzen dafür Gewinde.

Praxisbeispiel: Will man den Funkenflug beim Feuerzeug aufnehmen

und die Hand, die das Feuerzeug hält, noch abbilden, sollte man sie

mit mindestens 1 000 W beleuchten (siehe Aufnahme 2 mit

und 3 ohne Zusatzbeleuchtung in [SloMo Clips]).

Nebenbei: Die Dynamik wird oft in der Einheit Dezibel [dB]

angegeben. Der Zusammenhang zu Bits und Bytes erschließt sich aus

den folgenden Formeln:

x [dB] = 20 × log y bzw. y = 10x/20

Wobei x für den Wert in dB steht und y für die Anzahl der

Empfindlichkeitsstufen.

Damit entsprechen 8 bit (= 28 = 256) also 20 × log 256

= 48 dB, während 60 dB für 1060/20 =

1 000, also für ca. 10 bit (210 = 1 024) Dynamik

stehen. 12 bit wären somit ca. 72 dB. Das sind typische Werte.

Als technische Begriff wäre in diesem Zusammenhang der Signal-Rauschabstand zu nennen. Er gibt an, um wie viel stärker das Nutzsignal »belichtetes Bild« gegenüber störenden Effekten ist - nicht zuletzt entstehen Ladungen in einem Pixel (eigentlich: Fotozelle; ~»Solarzelle«) auch spontan und zufällig, völlig ohne Belichtung, allein thermisch bedingt. Und der Begriff full well capacity, der angibt wie viel Ladung eine Fotozelle überhaupt generieren kann bevor die Sättigung eintritt, mehr Licht also keine weiteren Ladungsträger erzeugt. Hier spielen großflächige Pixel ihre Vorteile bezüglich der Dynamik aus.

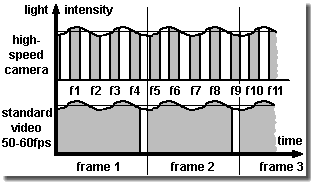

Zum Flackerbeleuchtung Effekt [SloMo Freq.]

Mehr über das Licht -

Foto hf:

Foto

Die Profis verwenden zumindest Halogenscheinwerfer in

Studioqualität (definierte Farbtemperatur ...), Kaltlichtquellen

(geringer Infrarotanteil), wenn nicht sogar HMI-Leuchten

(tageslichtähnliches Spektrum) und Gleichspannungsleuchten, um das

Flackern mit der 50 Hertz Netzfrequenz (1 Hz (Hertz) = 1/sek)

zu eliminieren.

Es gibt doch tatsächlich Lampen, die im Betrieb an und aus gehen,

ohne dass man es im Normalfall wahrnimmt. Selbst Leuchtdioden

(LED) können flackern, teils ungewollt wegen einer nicht gut genug

stabilisierten Gleichspannungsversorgung. Aber auch beabsichtigt -

denn der maximale Strom, und damit die (momentane) Helligkeit der

LEDs im Blitzbetrieb, darf nämlich deutlich höher sein als bei

kontinuierlichem Betrieb. (Geeignet synchronisiert werden sie

gerne eingesetzt, da sie kaum Wärme abstrahlen.)

Bei einer Aufnahme mit Licht hauptsächlich von den üblichen

Leuchtstoffröhren der Deckenbeleuchtung kann die Helligkeit

dann auch deutlich pumpen, siehe Abbildung links und für Details

[SloMo Freq.]

klicken. Der Effekt ist auch von den flimmernden Zeitlupenbildern

bei Fernsehübertragungen her bekannt. (Die gute alte Glühbirne

hatte also doch ihre Berechtigung. ;-)

Wegen der unterschiedlichen Farbtemperatur der Lichtquellen, z.B.

leuchtet die Wolfram-Glühwendel einer Halogenlampe langwelliger

oder wärmer (d.h. gelblicher, rötlicher) als Tageslicht, bieten

elektronische Kameras als Ausgleich den sogenannten Weißabgleich

(engl.: white balance) an. Dann wird Weiß wieder Blütenweiß.

Aber Vorsicht: Ein Halogenstrahler mit einer Nennleistung von

1 000 W heizt mit ca. 900 W. Das kann reichen, um

Plastik in weniger als 1 m Entfernung innerhalb von kurzer

Zeit anzuschmelzen.

Belichtungszeit und Blende

Funktionsweise von Shutter und (Apertur-) Blende

(Flüssigkristall-) LC-Shutter mit Displaytechs FLCs.

Vorgesehen für externe oder interne Montage.

Versorgung und Steuerung über die Kameraelektronik

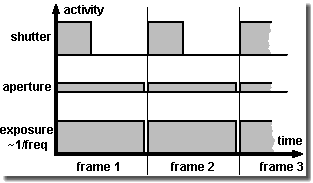

Die Belichtung, besser, die maximale Belichtungszeit von Hochgeschwindigkeitskameras, beträgt meist nahezu 1/Aufnahmefrequenz. Bei z.B. 1 000 Bildern pro Sekunde kann die Belichtungszeit pro Bild also allerhöchstens 1/1000 Sekunde betragen. Der Sensor integriert (= sammelt) während dieser Zeitspanne über die einfallende Lichtmenge.

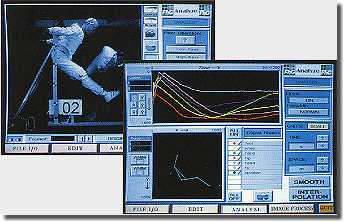

Der Sensor ist praktisch während der gesamten Belichtungszeit

eines Bildes aufnahmefähig. Die grauen Flächen unter den

Kurven im Bild rechts oben sind ein Maß dafür. Der schmale Spalt

zwischen den Bildern (engl.: frame) ist die Auslese- und/oder

Initialisierungszeit des Sensors im Bereich von einigen

Mikrosekunden oder weniger.

Das Schließen der Objektivblende (engl.: aperture, f-stop)

verringert die einfallende Lichtmenge global für alle Bilder. Je

größer die Blendenzahl, desto kleiner wird die Irisblende und desto

weniger Licht fällt auf den Sensor.

Ein Shutter (dt.: Verschluss) reduziert ebenfalls die einfallende

Lichtmenge, allerdings durch eine wiederkehrende (feste) Reduktion

der Belichtungszeit pro Bild. Technisch gesprochen ändert er das

Impuls-Pausen-Verhältnis (engl.: duty cycle) und verkürzt die Zeit

in der ein Bild effektiv aufgenommen wird.

Während die Blende also insgesamt die Belichtungsintensität

beschränkt, dient ein Shutter hauptsächlich dazu die

Bewegungsunschärfe zu reduzieren. Denn bewegt sich das Objekt in

der Belichtungszeit um mehr als 10% seiner Größe, wird dies

gewöhnlich als störend empfunden. (In der Fotografie akzeptiert man

gerade einmal bis 3%, falls überhaupt.)

Es gibt verschiedenen Methoden die Bewegungsunschärfe zu

reduzieren:

-

Die Aufnahmefrequenz erhöhen (was je nach Kameraeigenschaften unter Umständen eine Auflösungsreduktion nach sich zieht oder mehr Licht erfordert)

-

Ein Stroboskop einsetzen (wobei das Hintergrundlicht nicht zu stark sein darf, bzw. der Ausleuchtungsbereich des Stroboskops beschränkt ist)

-

Einen optionalen Verschluss einsetzen, z.B. einen liquid crystal-shutter (LC-Shutter), der Belichtungszeiten von ca. bis zu 1/10 000 Sekunde erlaubt, aber schon im offenen Zustand ca. zwei Blendenstufen kostet (Transmission ca. 30%).

Viele aktuelle Systeme verfügen standardmäßig über einen mehr

als zehn mal schnelleren elektronischen Verschluss im Chipdesign

und brauchen somit keinen zusätzlichen LC-Shutter.

Belichtungszeiten von Mikrosekunden und darunter sind weniger ein

technisches Problem, als ein Exportkriterium in Form von Dual

Use Beschränkungen (militärische Verwendung und

Proliferation).

Für diejenigen, die mehr wollen oder brauchen - in diesem Fall

kürzere Belichtungszeiten - hilft z.B. eine Kerr-Zelle oder eine

Pockels-Zelle, eventuell auch eine Mikrokanalplatte (engl.:

microchannel plate, MCP). Natürlich gibt es auch mechanische

Shutter und auch Chopper (dt.: Zerhacker) in Form von Spalten- oder

Lochrädern.

Anmerkung: Im Gegensatz zum oben beschriebenen, auf den gesamten

Sensor gleichzeitig operierenden globalen Verschluss (auch engl.:

snap-shot shutter, freeze frame shutter), gibt es auch den

zeilenweise arbeitenden rollierenden oder Schlitzverschluss (engl.:

rolling shutter). Für die Bewegungsanalyse sind Kameras mit

ersterem vorzuziehen, da bei diesem Zeilen-Scannen des Sensors nicht

gewährleistet wird das resultierende Bild zu einem definierten

Zeitpunkt aufzunehmen und entsprechende Artefakte entstehen

können.

Mit der Verschlusszeit kann man selbstverständlich auch die

Bildhelligkeit variieren, wenn man den Blendenring nicht verstellen

kann oder will. Letzteres betrifft mehr die künstlerische

Annäherung, denn die Schärfentiefe ist von der Blende abhängig. Mit

größerer Blendenzahl nimmt sie zu. Wers braucht...

Schärfentiefe (auch Tiefenschärfe)

Die Bezeichnung des Abstandsbereichs, in welchem Objekte

scharf abgebildet werden. Es ist deswegen nicht nur ein Punkt, wie

es die Aufschrift auf dem Entfernungsring (Fokus) nahe legt, weil

innerhalb eines Toleranzbereiches der Sensor oder auch das Auge

nicht besser auflösen können. Wird ein Punkt jeweils innerhalb des

sogenannten bildseitigen Unschärfekreises (auch Zerstreuungskreis;

ca. 0,01 mm bis 0,025 mm Durchmesser bei gängigen

Sensorformaten und 0,033 mm beim Kleinbildformat) abgebildet,

bemerkt man die Unschärfe nicht.

Die Lage und Ausdehnung ist maßgeblich von der Blende abhängig:

kleine Blende (= große Blendenzahl) - große Schärfentiefe. Wobei

sie sich hinter der rechnerischen Position des Fokusabstandes

weiter ausdehnt als davor.

Die Schärfentiefe wird gesteigert durch kürzere Brennweite und

größeren Objektabstand. Größeres Film-/Sensorformat bzw. genauer

größere Pixel ebenfalls, erlauben dagegen sie auch zu reduzieren.

(Wegen des Crop Faktors vergrößern geschrumpfte Sensoren die

Schärfentiefe zwangsweise.)

Es gibt eine etwas unhandliche Berechnungsformel, siehe

den Abstands- und Brennweitenrechner [SloMo f = ∞].

Aber Schärfentiefe ist sowieso ein Unwort bei

Hochgeschwindigkeitsaufnahmen in Industrieumgebung (meist ist die

Blende der »Finstermatik« sowieso bis zum Anschlag offen ;-).

Die Einstellung auf die sogenannte hyperfokale Entfernung h

bewirkt, dass von h/2 bis Unendlich scharf abgebildet wird. Dies

wird dann auch als Fixfokus oder Naheinstellung bezeichnet und wird

speziell bei einfachen Kameras eingesetzt.

Billige Objektive, speziell CS-Mount für Überwachungskameras,

verfügen oft nicht einmal über einen Entfernungsring. Sie werden

nur über die Blende scharf gestellt. Für die nötige Helligkeit

muss hier die elektronische Verstärkung (engl.: gain) der Kamera

sorgen.

Bildausschnitt und Objektiv

Die Aufgabe erfolgreich meistern: Das was interessiert

möglichst formatfüllend abbilden. Bei C-Mount geht es durchaus mit

Zwischenringen (im Set weniger als € 50,-) und Objektiven

fester Brennweite oder einer zusätzlichen Nahlinse ein Objekt mit

5 mm Durchmesser bildschirmfüllend aufzunehmen. Bei Aufnahmen,

die anschließend automatisch ausgewertet werden sollen (z.B. per

Bahnverfolgung), sollte man keine Weitwinkelobjektive mit

Brennweiten unter 6,5 mm wählen, da die Verzeichnung sonst

nicht mehr tolerierbar ist (bezogen auf C-Mount 2/3 Zoll Format).

Als Objektive und Zubehör kann man alles was für den entsprechenden

Mount passt verwenden, auch Filter, Makro-, Zoom- und

Fischaugenobjektive und mit entsprechenden Adaptern auch

Fotoobjektive, Balgen, Mikroskope, Endoskope, Boroskope,

Faseroptiken, Restlichtverstärker ... Nur sollte man beachten, je

komplizierter die Optik, desto mehr Licht braucht man meist.

Der Foto-Fachhandel bietet Adapter zum Anpassen gängiger

Objektivanschlüsse an, z.B. C-Mount auf Nikon Bajonett (Nikon F).

Einige Hochgeschwindigkeitskameras erlauben (wie auch viele

professionelle Standbildkameras) darüber hinaus - dank einer

Montageplatte/Referenzebene - die Wahl zwischen zahlreichen

(kunden-) spezifischen Adaptern, wie die verbreiteten Nikon F und

C-Mount sowie anderen wie z.B. PL, Kinoptik oder Stalex (M42).

Zum Brennweitenrechner [SloMo f = ∞]

Eigentlich gibt die Brennweitenaufschrift auf

Objektiven die bildseitige Brennweite bei Abbildung eines unendlich

weit entfernten Objektes bei 546 Nanometer Wellenlänge an. Dann

geschieht die Bilderzeugung im bildseitigen Brennpunkt.

Die Definition nach der DIN 4521 Norm lautet:

f' = limω-->0 (y'/tan ω)

Mit dem halben Feldwinkel ω und der halben

Bilddiagonalen y'.

(Im Folgenden wird der Feldwinkel wegen der formatfüllenden

Aufnahme vereinfachend, aber praxistauglich, mit dem Bildwinkel

gleichgesetzt und f' mit f als der Brennweitenbeschriftung des

Objektives. Und alles in SI Einheiten.)

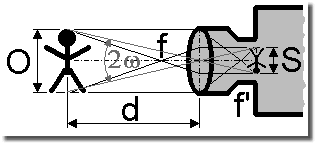

Die Faustformel zur überschlägigen Berechnung der nötigen Brennweite zur format- oder sensorfüllenden Abbildung S lautet

Brennweite = Distanz zum Objekt / (1 + Objektgröße / Bildgröße)

Und die Abschätzung für die nötige Distanz bei gegebener Brennweite lautet

Distanz zum Objekt = Brennweite × (1 + Objektgröße / Bildgröße)

Der Bild- oder Öffnungswinkel 2ω (engl.: angle of view, field of view; ≡ 2ω', siehe Bild oben) ergibt sich aus

2ω = 2 × arctan (1/2 × Bildgröße / Brennweite)

Die Vergrößerung V ergibt sich aus der Linsenabbildung auf den Sensor und aus der Darstellung des Bildes auf dem Monitor oder anderen Medien

V = Brennweite / (Distanz zum Objekt - Brennweite) × Monitordiagonale / Sensordiagonale

Man muss aber die Beschränkungen von Standard-Objektiven

beachten. Unterhalb eines Abstands von 0,3 m (manchmal auch

1 m) zum Objekt lassen sie sich nicht mehr scharfstellen. Bei

einem solchen Anwendungsfall braucht man Zwischenringe, eine

Nahlinse oder ein Mikro(skop)-Objektiv, etc.

Die Dicke t des Zwischenringes, der zwischen Objektiv und

Kameragehäuse eingeschraubt wird, ergibt sich aus

t = Bildgröße / Objektgröße × Brennweite

wobei der Bruchausdruck Bildgröße / Objektgröße der Abbildungsmaßstab ist. Aber Vorsicht, so einfach sie auch sind - Zwischenringe fressen Licht.

Feineinstellung des Auflagemaßes

Der Fehler beim Auflagemaß ergibt sich offensichtlich

durch Fertigungstoleranzen, Fehlanpassungen (Inkompatibilität von

Komponenten) und in den Strahlengang zwischen Objektiv und Film

bzw. Sensor eingebrachte Medien. Und bei crashfesten Kameras geht

die mechanisch Festigkeit über alles, auch über (zu filigrane)

Justagemechaniken.

Vorausgesetzt man verwendet den passenden Adapter kommt man bei

einem Objektiv mit fester Brennweite durch drehen des

Entfernungsrings (Fokus) normalerweise problemlos zu scharfen

Bildern. Mag sein, dass dann der Entfernungsaufdruck und der

Bildvergrößerungsfaktor nicht ganz stimmen. Meistens stört das aber

nicht weiter.

Beim Zoom Objektiv dagegen verliert man während des Zoom Vorganges

an Bildschärfe (d.h. den Fokus). Eigentlich sollte sie gleich bleiben und sich nur

die Vergrößerung (und damit der Bildausschnitt) verändern. Das Zoom

Objektiv ist dann nur eingeschränkt als Vario Objektiv verwendbar.

Zeitgleich zum Zoomen müsste man immer wieder scharfstellen.

Allerdings wird bei Hochgeschwindigkeitskameras eher selten mit

solchen Zoom Fahrten gearbeitet.

Zur vollen Nutzung der Zoom Fähigkeit muss das Auflagemaß jedoch

genau eingestellt werden. Mit einfachen Mitteln geschieht dies wie

folgt:

-

Blende maximal öffnen, um die Schärfentiefe zu reduzieren (gegebenenfalls den Raum abdunkeln, die Belichtungszeit verkürzen, ...)

-

Ein ca. 3 m bis 7 m entferntes Objekt auswählen

-

Das Bild bei maximalem Zoom (größte Brennweite) mit dem Entfernungsring scharfstellen

-

Das Bild bei minimalem Zoom (kleinste Brennweite) durch Änderung des Auflagemaßes scharfstellen. (Der Entfernungsring dabei nicht verstellen)

-

Solange iterieren, bis das Bild in beiden Zoom Positionen ohne Nachkorrektur scharf bleibt

Zur Einstellung des Auflagemaßes verfügen Kameragehäuse entweder

über eine in Längsrichtung verschiebbare Gewindebuchse - praktisch

Standard bei C-Mount Kameras. Oder es werden Unterlegbleche

zwischen Objektivadapter und Kamerakörper eingelegt, wenn nicht

sogar im Kamerakörper eine Mechanik zur Änderung der Sensorposition

integriert ist. Auch gibt es Objektive, vor allem mit C-Mount, bei

denen der kameraseitige Gehäusezylinder verschoben werden kann.

Suchen Sie nach einer kleinen Madenschraube im Umfang.

Der IR-Umschalter an hochwertigen Objektiven macht nichts anderes.

Er schiebt das Objektiv quasi nach vorne, damit die IR Bilder auf

dem Sensor abgebildet werden.

Auswertung und Messung

Doch bitte vergessen Sie nicht: Sie erhalten große Datenmengen. Eine Megapixelauflösung bei 1 000 Bilder/sek und mehr zieht nun einmal Datenraten im Gigabyte/sek Bereich nach sich. Also mehr als eine CD-R pro Sekunde würde gefüllt werden. Und das wohlgemerkt pro Kamera. (Hier in [SloMo Daten] finden Sie die Formel zur Abschätzung der Datenmenge.) Wundern Sie sich also nicht, wenn das Hochgeschwindigkeitskamerasystem beim Download, Abspeichern und Abspielen dieser Dateien ziemlich beschäftigt ist. Und - man sollte sich wirklich vorher ein Konzept für speichern und archivieren der Dateien überlegen.

Die großen Datenmengen sorgen dafür, dass man die Kameras

offline einsetzt. Sie somit nicht unmittelbar zur Steuerung

heranzieht und sie nicht direkt in eine übergeordnete

Maschinensteuerung einbindet. Die Bildverarbeitung wäre einfach zu

aufwändig und zu langsam. Man sieht zu und analysiert

nachträglich.

(Langsamere Kameras aus dem Bildverarbeitungssektor -

»Machine Vision« Sensoren - können schon heute mit

soviel Rechenleistung versehen werden, daher Smart Kameras genannt,

dass sie wie ein Sensor arbeiten und nur noch ein Gut-/Schlechtsignal - z.B.

»Etikett richtig auf die Flasche geklebt - Ja/Nein?« - an die

Steuerung weitergeben und keine Bilddaten zur weiteren

Verarbeitung.)

Trajektorienauswertung: Translation, Rotation,

Geschwindigkeit, Beschleunigung und Animation

Für die Steuerung von Hochgeschwindigkeitskameras, auch für

Mehrkanalsysteme unterschiedlicher Hersteller, ist spezielle

Software verfügbar. Die Auswertung erfolgt entweder direkt visuell

oder mit Bewegungsanalyse-Software Paketen, sogenannten Motion

Tracker. Siehe z.B. die entsprechenden Links in [SloMo Links].

Für die automatische Objektverfolgung mittels Software sollte man

darauf achten, dass der Hintergrund möglichst einheitlich gestaltet

ist, also keine Gitter-, Schachbrettmuster oder vergleichbares (so etwas wie eine

Blumentapete ;-). Das reduziert die Rechenzeit und verhindert, dass

die Such- und Verfolgungsalgorithmen ihre Attraktoren im

Hintergrund finden und hängen bleiben anstatt das gewünschte Objekt

zu verfolgen.

D-Laden

Falls Sie beabsichtigen die Bilddateien im AVI Format zu

archivieren, überlegen Sie sich den Einsatz der Komprimierungstools

Intel Indeo oder DivX und sparen Sie bis zu 90%

Speicherplatz ohne nennenswerten Qualitätsverlust. DivX liefert

meist kleinere Dateien, speziell wenn sich wenig im Bildausschnitt

bewegt. Indeo dagegen empfiehlt sich für die automatische

Weiterverarbeitung, da es die Positionen der Objekte weniger stark

manipuliert.

Die AVI Dateien kann man z.B. mit Videobearbeitungs-Soft-/Freeware

bearbeiten (d. .h. Bildformat, Abspielgeschwindigkeit ... ändern).

Für diese und andere Hilfsmittel schauen Sie einfach einmal

hier im Download Zentrum nach, siehe Knopf links.

Man nimmt zwar mit Super-Zeitlupe auf, um sich schnelle Vorgänge

verlangsamt anzusehen, trotzdem sollte man auch einmal schneller

abspielen, z.B. mit 25 bis 100 Bilder/sek (bei einem Original mit

1 000 Bilder/sek), sonst geht der Bewegungseindruck verloren.

Das gilt vor allem dann, wenn man die Aufnahmen Außenstehenden, die

mit der Szenerie nicht so vertraut sind, zeigen will.

Da die Hochgeschwindigkeitskameras auch mit der normalen

Geschwindigkeit von 50 Bilder/sek betrieben werden können, ist es

möglich einen regelrechten Videoclip zu drehen. Und mit dieser

Aufnahmefrequenz auf USB Stick überspielt, kann man ihn dem

Kunden, für den man die Anlage gebaut hat, mit den Worten

übergeben: »So ist ihre Maschine in der Endkontrolle gelaufen.«

Kommt nicht nur bei den hochauflösenden Kameras wirklich gut. So

wird der Versuch zum Werbefilm.

Tricks zur Systemintegration

Trigger und Synchronisation

Der englischsprachige Ausdruck Trigger(n) bedeutet nichts

anderes als einmaliger Auslöser. Beispielsweise wird die Aufnahme

gestartet, wenn das Crashtest-Auto gegen die Wand fährt. Der

Triggergeber ist dabei oft ein schlichter Kontakt an der

Stoßstange, der beim Aufschlag kurzschließt, oder eine

Lichtschranke. (Oft markiert ein Blitzlicht zusätzlich

»Bild 0«.)

Synchronisieren bedeutet die Aufnahmefrequenz zu einem

periodischen Ereignis über einen gewissen Zeitraum in einem

definierten Verhältnis und einem festen zeitlichen Versatz zu

stabilisieren. Idealerweise geschieht dies durch ein

wiederkehrendes Steuersignal, das jedes Mal einen Bildeinzug

auslöst. So wird man, wenn man ein Stroboskop als

Beleuchtungsquelle nutzt, die Aufnahmephase der Kamera so legen,

dass sie immer dann aufnimmt, wenn das Stroboskop blitzt. Man wählt

die Aufnahmefrequenz gleich der Blitzfrequenz und legt den

Bildeinzug so, dass die Kamera während des Blitzes auch aktiv ist,

ihr Verschluss nicht etwa gerade zu ist, und sie somit den relativ

kurzen Lichtblitz auch sehen kann.

Manchmal bieten Kameras auch ein sogenanntes »Strobe«-Steuersignal

an. Es markiert die Belichtungszeit jedes Bildes; während die

Kamera belichtet, ist es gesetzt.

So ganz trivial ist das Triggern gar nicht. Denn immerhin muss eine synchron laufende Kamera kurzfristig auf einen asynchronen Triggerimpuls reagieren. Da kann es schnell zu einem Bildversatz kommen, weil die Kamera erst noch den vorherigen Bildeinzug beenden muss. Da bei Triggerauslösung der Ring-Bildspeicher ja zu einem bestimmten Teil bereits fest beschrieben sein kann, besitzen Hochgeschwindigkeitskameras nämlich oft keine sogenannte Restartfähigkeit, wie sie Videokameras ohne Bildspeicher bieten können. Letztere sind in der Lage fast zeitgleich mit dem Trigger eine neue Aufnahme zu starten. (Frühere Bilddaten werden gegebenenfalls verworfen.)

Wenn man verschiedene Geräte triggern oder

synchronisieren will, sieht man sich schnell mit unterschiedlichen

Signalpegeln, Impulsdauern und Phasenlagen konfrontiert, die

einfach nicht zusammenpassen wollen.

Deshalb hier auf der linken Seite eine ganz einfache und

preiswerte Schaltung, siehe auch [SloMo Trig.] für

die Beschreibung, die hilfreich bei der Anpassung sein kann.

(Denn nicht überall wo »Trigger« drauf steht, ist auch Trigger

drin. ;-)

Gerade bei Mehrkanalaufnahmen, und besonders bei 3-D-Vermessungen, wird die Synchronisation der Kameras zueinander und generell ihre Triggerung außerordentlich wichtig.

Im-Bild-Trigger und externer Trigger

Die CMOS Technik macht es möglich. Die Triggerauslösung erfolgt anhand des Bildinhalts, sobald in einem vordefinierbaren Ausschnitt des (Live-) Bildes eine Farbänderung einen ebenfalls vordefinierbaren Schwellwert bei einer bestimmten Pixelanzahl überschreitet. Elegant, aber was, wenn man auf ein elektrisches Triggersignal von außen reagieren muss, doch dafür kein Anschluss vorhanden ist - z.B. am Smartphone? Einfach eine LED ins Bild hängen und vom externen Trigger ansteuern lassen. Das ist dann der sinnvolle Triggerbereich. Einen kleinen Zeitversatz wird es aber geben. Man könnte ihn doch sogar mal messen?!

Fernsteuerung

Die Aufgabe: Eine Kamera soll eingestellt werden (Aufnahmebereich, Blende, Schärfe, Belichtungszeit, Trigger, Format ...), aber der Steuerrechner steht in größerer Entfernung, z.B. in der Warte hinter einer Sicherheitsschleuse, so dass man an der Kamera kein Livebild hat. Oder man möchte das Kamerasystem aus größerer Entfernung steuern.

Die üblichen Schnittstellen (Gigabit Ethernet, etc.) sind zwar

ausreichend schnell, man ist aber oft auf eine teure Steuersoftware

des Kameraherstellers oder einer Drittfirma angewiesen. (Und WLAN

ist so eine Sache - entweder die Kamera kann es gar nicht oder man

ist wegen der sensiblen Daten etwas eigen.)

Warum versuchen Sie es nicht einmal mit einer preiswerten KVM? Ein

Keyboard-Video-Maus

Extender (oder Switch) bietet eine leistungsfähige Fernsteuermöglichkeit

ohne Eingriffe in den Rechner. Selbst zusätzliche Treiber/Software

sind nicht nötig.

Der KVM besteht aus einem Sendegerät und einem Empfangsgerät, die

im einfachsten Fall mit einem normalen Cat 5 UTP Ethernet-Kabel

verbunden sind. Das Sendegerät wird am Steuerrechner anstelle von

Tastatur, Maus und PC Monitor angeschlossen. Am Empfänger schließt

man dann die tatsächlichen Peripheriegeräte an. Jetzt kann man am

Empfänger arbeiten als würde der Rechner neben einem stehen.

Je nach gewähltem Gerät bzw. Übertragungstechnologie

sind Entfernungen von etlichen zehn Metern bis zu über einigen

hundert Metern möglich.

Inzwischen können All Share®, Airplay® oder was auch immer ein

Ersatz sein. Oder gar ein WLAN Bildschirm. Aber unterschätzen Sie

nicht die Verzögerung, um die Bilder durch die Luft zu schicken und

anzuzeigen, speziell wenn Sie sie zum händischen Triggern nutzen

wollen. Ausprobieren!

Automatische Anmeldung (engl.: Autologon) und automatischer Start

Die Aufgabe: Ein Windows PC mit oder ohne Ethernetanschluss soll selbständig hochlaufen. Im Spezialfall sogar ohne angeschlossene Tastatur, Maus und Monitor.

Die Passwort Abfrage kann man mit der Autologon-Funktion von

Windows umgehen. (Achtung: Danach steht das Passwort für das

System und die Netzwerkverbindung in der Regestry.) Man legt ein

neues Benutzerkonto ohne Passwortabfrage an bzw. stellt ein

bestehendes entsprechend ein.

Bei Belieben in den Startmenü

Programmen unter Autostart das automatisch zu startende

Programm (oder seine Verknüpfung) ablegen.

Aktiviert man im Bios noch »halt on no errors«,

veranlasst man den Rechner nicht darauf zu warten, dass sich eine

Tastatur oder eine Maus zurückmelden. Das macht Sinn, wenn man

das System über eine separate Fernsteuerung bedienen kann.

Ergebnis: Das System läuft hoch bis zum Windows Desktop,

und mit dem gewünschten Programm in Verzeichnis

Autostart hinterlegt, sogar bis zur Ihrer Anwendung.

Im Zweifelsfall einfach in der Windows Hilfe nachsehen.

Reinigung von Objektiven, Sensoren und LC-Shutter

Die Experten am Zug - natürlich hat niemand auf das

Objektiv gefasst und erst recht hat keiner es unabgedeckt

herumstehen lassen bis sich ein regelrechter Staubhügel darauf

angesammelt hat. Abblasen hilft nicht mehr und bei einem

mechanischen Reinigungsversuch hat man nur allzu oft das Gefühl den

Dreck allenfalls gleichmäßig zu verteilen. Ganz abgesehen davon,

dass bei der Verwendung eines trockenen Tuches Kratzer in der

vergleichsweise empfindlichen Antireflex-Beschichtung drohen.

Alkoholgetränkte (Isopropanol) Wattestäbchen, feuchte

Brillenputztücher oder Fensterleder mit wasserverdünntem

Geschirrspülmittel oder Fensterreiniger (und weiches Wischpapier

zum Entfernen der Rückstände!) sind wesentlich besser.

Das ultimative Mittel gegen Fingerabdrücke und Dreck auf Glas

aber ist z.B. First Contact Polymer (ersetzt Opticlean Polymer von

Dantronix) - nicht ganz billig, aber endgültig; oder eben doch

die Staubschutzkappen ;-).

Normalerweise sind die Sensoren von Kameras durch eine fallweise

beschichtete, d.h. optisch vergütete, Glasscheibe geschützt.

Speziell bei Fotoapparaten und Schwarz/Weiß Auslegungen kann in

manchen Fällen der Chip allerdings offen sein. Dann ist wegen des

empfindlichen Farbfiltermuster-Films (Polymer) oder der

Chipoberfläche und seiner Bonddrähte Vorsicht bei der Reinigung

geboten. Es ist sehr zu empfehlen den LC-Shutter, wenn überhaupt,

wesentlich vorsichtiger zu reinigen als man das von

Glasoberflächen her gewohnt ist.

Wenn keine Spannung am LC-Shutter anliegt, kann er Flecken und

Einschlüsse zeigen, die ihn kaputt aussehen lassen. Keine Sorge,

die Steuerspannung löscht sie alle. Das kann man ganz einfach

überprüfen, wenn man ihn an der mit niedriger Frequenz laufenden

Kamera betreibt und versucht durch ihn zu blicken. Oder wenn man

abwechselnd Gleichspannung (±5 V? Bedienungsanleitung prüfen!)

an den LC-Shutter anschließt und durch ihn blickt. Er macht dann

ganz auf und ganz zu.

Die [TOUR] zeigt Bilder, Informationen und Technische Daten zu den SpeedCam Systemen als Beispiel für die Eigenschaften digitaler Hochgeschwindigkeitskameras.