Bildspeicher digitaler Hochgeschwindigkeitskameras

Wohin nur mit den Bilddaten?

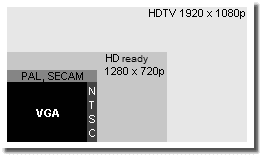

VGA, traditionelle und neue TV Formate

Daten über Daten: Schon bei einer VGA Auflösung von 640 x 480 Pixel und einer Aufnahmerate von lediglich 100 Bilder/sek fallen bereits gut 30 Megabyte Daten pro Sekunde an. Das ist aber mit gängigen Schnittstellen und Massenspeichern noch handhabbar, mit USB 3.0 sogar 800 Bilder/sek. Deshalb gibt es für Megapixel Auflösungen und um 300 Bilder/sek den Framegrabber / Steuereinheit Ansatz mit der CoaXPress Schnittstelle. Ein Konzept das nie ganz überholt ist, da das Problem die riesigen Datenmengen los zu werden immer präsent ist.

Bildgewinnung und Datenübertragung

Aufnahmetechnik

Digitale Hochgeschwindigkeitskameras sind nicht nur durch die Auflösung ihrer Sensoren beschränkt, sondern auch durch die Ausleserate der Sensoren und die Datenübertragungsrate zu ihren Speichermedien sowie deren Kapazität (engl.: auch Frame Buffer). Die maximalen Auslese- und Datenübertragungsraten begrenzen je nach Realisierung die Aufnahmefrequenz und/oder die auslesbare Fläche des Bildsensors, während die Speicherkapazität des Pufferspeichers für die vergleichsweise kurze Dauer der Sequenzen verantwortlich ist. Der Pufferspeicher kann sich im Kamerakopf befinden oder auf einer Einsteckkarte in der Steuereinheit.

|

Name |

Übertragungsrate | nominell | max. Kabellänge |

|---|---|---|---|

| Fast Ethernet (100 Base T) |

100 Mbit/s | 12,5 Mbyte/s | 100 m |

| Gigabit Ethernet (1000 Base T) |

1000 Mbit/s | 125 Mbyte/s | 100 m |

| FireWire 400 (IEEE 1394a) |

~400 Mbit/s | 40 Mbyte/s | 4,5 m (14 m) |

| FireWire 800 (IEEE 1394b) |

~800 Mbit/s | 88 Mbyte/s | ... (72 m) |

| USB (1.1 Full Speed) |

12 Mbit/s | 1,5 Mbyte/s | 3 m |

| USB 2.0 High Speed |

480 Mbit/s | 60 Mbyte/s | 5 m |

| USB 3.0 Super Speed |

5000 Mbit/s | 625 Mbyte/s | 3 m |

| USB 3.1 | 10 Gbit/s | 1212 Mbyte/s | 1 m |

| USB 3.2 | 20 Gbit/s | 2,5 Gbyte/s | 0,5 m |

| USB 4.0 / Thunderbolt 4 | 20 / 40 Gbit/s | 2,5 / 5 Gbyte/s | 0,5 m |

Verschiedene PC Schnittstellen im Vergleich (1 bit = 1/8 byte)

Es gibt natürlich auch Hochgeschwindigkeitskamerasysteme deren

Auflösung und Aufnahmefrequenz noch einen Dauerbetrieb, ähnlich

einem Videorekorder, über eine deutlich längere Zeitspanne

erlauben. Sie speichern ihre Daten entweder auf ein Magnetband

(ältere Modelle) in der Steuereinheit oder direkt auf die

Platte eines Steuerrechners - Streaming.

Die Anbindung der Kamera(s) ist eine vielschichtige Aufgabe.

Vorrangig geht es einmal um den Datenaustausch - Bilddaten

zurück und Steuerdaten hin (und evtl. auch her). Einfach in

nüchternen Zahlen ausgedrückt: Ein Megapixelsensor,

selbst mit vergleichsweise bescheidenen 8 bit Farbtiefe pro Kanal,

generiert bei 1 000 Bilder/sek immerhin 1 Gigabyte, also

1 000 Megabyte, Daten pro Sekunde im RAW Format. Diese Masse

an Daten will erst einmal übertragen und dann noch gespeichert

sein. Selbst das schnelle Gigabit Ethernet (= 1 000

Megabit/sek) bietet nur eine nominelle Übertragungsrate von 125

Megabyte/sek (1 bit = 1/8 byte). Davon bleiben etwa 100

Megabyte/sek effektiv übrig, verursacht durch einen gewissen

Verwaltungsaufwand. Gleiches gilt für USB 3.0 mit etwa 500

Megabyte/sek nutzbarer Übertragungsrate. Intel

Thunderbolt 3 oder 4, bzw. USB 3.2 oder 4 mit zumindest 20

Gigabit/sek wären toll, wenn es die beschränkten

Kabellängen nicht gäbe. Kann man bei den Bilddaten noch

auf die Echtzeitforderung verzichten, geht das bei den

Steuerdaten nicht mehr. Was dann auch noch Anforderungen an ein etwaiges

Betriebssystem stellt.

Dann benötigen die Kameras auch noch (ordentlich) Strom, was

auch bei der Kabellänge, speziell der Einkabellösung, zu

beachten ist.

Zu guter Letzt kommen noch Sicherheitsüberlegungen dazu. Oft

arbeitet man im Bereich Forschung und Entwicklung und nicht jede

Firma will ihren »Erlkönig« per Funk oder WLAN

übertragen wissen.

Das macht Speicherkonzepte innerhalb des Kamerakopfes

weiterhin interessant, und bezahlbare Solid

State Disks ohne bewegliche Teile ergänzen

die konventionellen Festplattenlaufwerke, wenn man nicht auf teure,

aber schnelle DRAMs setzt.

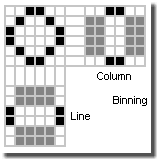

Binning und Formatanpassung

Die technischen Maßnahmen, um bei beschränkter Ausleserate die Aufnahmefrequenz zu steigern, hängen maßgeblich von der Architektur des Sensors ab. Bei CCD Sensoren bietet sich eher eine Zeilen- oder Spaltenreduktion z.B. in Form des Binning (dt.: zusammenfassen) an, was bedeutet, dass zwei benachbarte Pixelreihen zusammengezogen werden und wie eine ausgelesen werden. Bei CMOS Sensoren, die ähnlich DRAMs aufgebaut sind und mehr oder weniger pixelweise adressiert werden können, ist es eher die Reduzierung des Aufnahmeformats, einfach durch die Verringerung des Auslesebereichs, also einer geringeren Pixelanzahl.

Zeilen-/Spaltenbinning

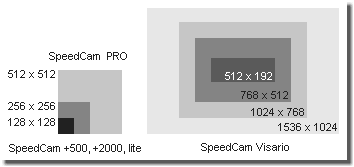

Vergleich der SpeedCam Bildauslesebereiche

So nutzen beispielsweise SpeedCam +500/+2000/lite (Dalsa CA-D1-0128A, CA-D1-0256A CCD) Zeilenbinning, SpeedCam 512/PRO (EG&G Reticon HS0512JAQ CCD) Spaltenbinning und SpeedCam Visario (FhG/CSEM Cam 2000 Visario CMOS) Formatanpassung. Zum Vergleich der (maximalen) Auflösungen siehe die rechte Abbildung.

Während beim Binning der Bildausschnitt gleich bleibt, und die

Einsparung an auszulesenden Pixel über eine Auflösungsreduktion

erkauft wird - Zeile oder Spalten werden zusammengelegt - spart man

bei der Formatanpassung Pixel durch einen Schlüssellocheffekt

ein. Binning macht die Bilder unschärfer, die Formatanpassung

macht sie dagegen bei gleichbleibender Qualität kleiner. Im

Endeffekt läuft es aber auf das gleiche hinaus: Will man bei

der Formatanpassung wieder den selben Bildausschnitt, muss man

näher hin oder das Bild größer ziehen - das Bild wird

pixeliger. Binning macht das ganze ohne Standortänderung bzw.

Fokusänderung.

Man kann nicht global sagen was besser ist. Bei Einstellarbeiten

wird man es zu schätzen wissen, dass man an Objektiv und der

Kamera keine Änderungen (insbesondere bei der Belichtung)

vornehmen muss, wenn man mit der Aufnahmefrequenz hoch geht.

Andererseits hat es natürlich auch seine Vorzüge, wenn die

Bilder immer die gleiche Auflösung bieten. In der Praxis setzt sich

die Formatanpassung mehr durch: Qualität zählt. Diese Entwicklung

wird natürlich auch durch den zunehmenden Einsatz von CMOS Sensoren

forciert, die dafür durch ihren Aufbau prädestiniert sind.

Ausleseverfahren (Zeilensprungverfahren, engl.: interlaced, non-interlaced; progressive scan)

Das Auslesen des Sensors ist in gewissem Umfang vergleichbar mit der Darstellung auf Bildschirmen. Im einfachsten Fall werden wie beim Zeilensprungverfahren (engl.: interlaced) am Röhren-Fernseher Halbbilder verwendet. Das menschliche Auge ist zu träge, um den Trick zu durchschauen. Erst bei der Standbildwiedergabe erkennt man durch die üblichen Artefakte den Betrug, siehe auch [SloMo Freq.].

-

2:1 interlaced Betrieb im Frame Integration Mode: Das erste Halbbild besteht aus allen ungeraden Zeilen, das zweite Halbbild aus allen geraden. Die beiden Halbbilder werden nacheinander ausgelesen, aber zusammen dargestellt. Nachteil: Ein Bild besteht eigentlich aus zwei zeitversetzten Aufnahmen, die zeilenweise gemischt werden. Zeile 1, 3, 5 ... sind z.B. die vom aktuellen Zeitpunkt, während die Zeilen 2, 4, 6 ... noch das vorherige Bild zeigen. Im nächsten Schritt werden dann die geraden Zeilen mit einem neuen Bild belegt, während die ungeraden noch das alte zeigen, usw. Deswegen die typischen sogenannten Kammfehler bei bewegten Szenen, aber die volle bildliche Auflösung bleibt erhalten.

(Im Falle des Deinterlacings bei der Videowiedergabe vergleichbar mit »weave«.) -

2:1 interlaced Betrieb im Field Integration Mode: Zwei Zeilen werden schon beim Auslesen zusammengefasst (engl.: Binning) und entsprechend dargestellt. So ergeben beim ersten Halbbild Zeile 1 und 2 die Zeile 1, die Zeilen 3 und 4 die Zeile 3, usw. Im zweiten Halbbild ergeben Zeile 2 und 3 die Zeile 2, die Zeilen 4 und 5 die Zeile 4, usw. Dadurch wird die Auflösung reduziert, es gibt unter Umständen Treppenartefakte an Kanten. Dafür ist aber die zeitliche Auflösung besser, etwaige Bewegungsunschärfe also geringer.

(Im Falle des Deinterlacings bei der Videowiedergabe entfernt vergleichbar mit »field averaging«.) -

Non-interlaced: Es werden Halbbilder aufgenommen, die gegebenenfalls durch Verdopplung der Zeilen zu Bildern mit voller Auflösung ergänzt werden. Semiprofessionelle (VHS/SVHS) Videorekorder können (konnten ;-) oft in diesem Modus arbeiten. Auflösung kann verloren gehen, aber die zeitliche Zuordnung ist eindeutig.

(Im Falle des Deinterlacings bei der Videowiedergabe entfernt vergleichbar mit »bob« (Interpolation der fehlenden Zeile pro Halbbild) bzw. »skip field« (nur jedes zweite Halbbild wird angezeigt, seine Fehlzeilen werden interpoliert).) -

Progressive scan: Der Sensor wird komplett und (möglichst) zu einem Zeitpunkt ausgelesen. Höchste bildliche und zeitliche Auflösung. Technisch aufwändig, aber das ergiebigste Verfahren für Hochgeschwindigkeitsaufnahmen und Bewegtbildanalyse.

(Vollbilder, sogenannte »frames« gibt es in der traditionellen TV/Videotechnik nicht. Sie kennt nur Halbbilder, sogenannte »fields«.)

Für Hochgeschwindigkeitsaufnahmen ist progressiv scan das Mittel der Wahl. Die interlaced Verfahren können aber im Bereich der Standardbildverarbeitung (»Machine Vision«) die Datenraten reduzieren und wegen der Doppelbelichtung und des eventuell optimierten Füllfaktors des Sensors die Lichtempfindlichkeit steigern.

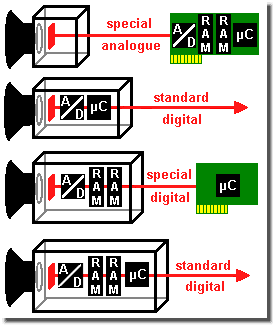

Bildspeicherung

Pufferspeicher

Die Bilddaten fallen je nach Sensortyp analog oder

bereits digital an. Analoge Bilddaten werden normalerweise erst

noch digitalisiert, bevor sie gespeichert werden. Die Speicherung

erfolgt üblicherweise zuerst in einer Art Puffer, es gibt aber auch

Ausnahmen. Sein Integrationsort ist je nach Stand der Technik und

den Anforderungen an die Kamera bzw. an das Kamerasystem

unterschiedlich.

Sogar die - natürlich stark begrenzte - Zwischenspeicherung auf

dem Sensor selbst wird praktiziert. Speziell bei besonders

schnellen Kameras.

Ist die Datenrate niedrig genug können die Bilddaten auch direkt

auf ein Speichermedium (z.B. die Festplatte eines Notebooks)

gestreamt werden. Bei richtigen Hochgeschwindigkeitskameras, die

ihrer Bezeichnung gerecht werden, ist es deshalb keine Option.

Konzepte für Hochgeschwindigkeitskameras

Legende zum Bild links: RAM = Bildspeicher; µC =

Mikrocontroller oder Prozessor; A/D = Analog zu Digital Wandlung

(oft schon im Sensor integriert)

Die grüne Karte soll eine PC-Einsteckkarte darstellen, die rote

Leitung die Anschlussmöglichkeit (Bilddaten und

Steuersignale).

Die Standardanbindung kann z.B. (Gigabit) Ethernet oder FireWire

sein.

Und so kann eine crashfeste digitale Hochgeschwindigkeitskamera von innen aussehen, siehe [SloMo HYCAM].

Bei Kameras ohne A/D-Wandlung auf dem Sensorchip oder im

Kamerakopf werden die Bilddaten analog zum Steuerrechner übertragen

und dort erst digitalisiert und abgespeichert. Das erlaubt den

Kamerakopf selbst klein zu halten und auch seine Leistungsaufnahme

(Abwärme!) ist moderat. Allerdings sind die Anforderungen an die

Kabel wegen der anlogen Übertragung vergleichsweise hoch. Digitale

Kameras dagegen wandeln die Bilddaten bereits auf dem Sensorchip

oder im Kamerakopf und speichern sie dort bevorzugt zwischen.

Wegen der begrenzten Kapazität wird der Pufferspeicher in einer

Art Endlosschleife immer wieder beschrieben. Der Triggerimpuls

steuert diesen Prozess und die Bilder sind im Kasten.

Dieser Pufferspeicher, der in der Regel noch recht rohe Bilddaten

ohne Farbalgorithmik (engl.: RAW = dt.: roh) enthält, ist meist aus

DRAM (Dynamic Random Access Memory, dt.: dynamisch Speicher mit

wahlfreiem Zugriff) Schaltkreisen, wie man sie ähnlich von den

Speicherriegeln des PC Arbeitsspeichers her kennt, aufgebaut. Mit

der typischen Eigenschaft von DRAMs bei Stromausfall den

Speicherinhalt zu verlieren.

Speicherbausteine, die ihre Daten fest, also auch im stromlosen

Zustand behalten, sogenannte NVRAMs, SRAMs, Flash (non volatile,

dt.: nicht flüchtig; Static RAM, dt.: dauernd), werden wegen

verschiedener Nachteile wie niedrigere Geschwindigkeit, höherer

Preis, höhere Stromaufnahme, geringere Lebensdauer ... als

Pufferspeicher kaum eingesetzt.

Man behilft sich entweder mit einem Stützakku, der wenigstens den

Pufferspeicher im Bedarfsfall versorgt, oder gleich mit einem

Betriebsakku, der die komplette Kamera funktionstüchtig hält.

Manchmal auch mit einer USV für das komplette Kamerasystem,

speziell bei Systemen, die ihre Daten erst im Steuerrechner

puffern.

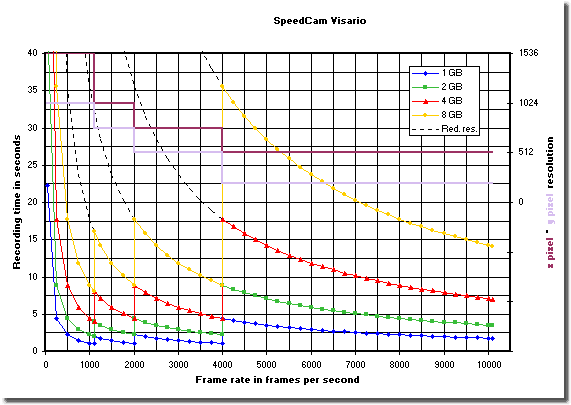

Bildspeicher, Auflösungsstufen, Frequenz und Aufnahmedauer

von SpeedCam Visario Hochgeschwindigkeitskameras

Zur Erklärung des Diagramms auf der rechten

Seite:

Die linke Hochachse gibt die bei eingestellter Aufnahmerate

maximal mögliche Aufnahmedauer an. Die rechter Hochachse zeigt die

maximal mögliche x pixel × y pixel Auflösung in

Abhängigkeit von der Aufnahmerate an. Diese Reduktionsstufen sind

zum besseren Verständnis mit eingezeichnet.

Die Sprünge bei der Aufnahmedauer ergeben sich durch die

Reduktionsstufen der Auflösung bei steigenden Aufnahmefrequenzen.

Behält man die Reduktionsstufe bei geringeren Aufnahmefrequenzen

freiwillig bei, kann man die Aufnahmedauer fallweise deutlich

verlängern. Man bewegt sich dann längs der gestrichelten Linien.

Begrenzt ist die Aufnahmedauer in diesem Fall unter Umständen

durch die Minimalfrequenz des Systems. Sie liegt bei 50 Bilder/sek

für SpeedCam +500 und SpeedCam PRO, bei SpeedCam Visario beträgt

sie ca. 10 Bilder/sek.

(Die Kurvenpunkte sind nur dazu da, um bei einem Schwarz/Weiß

Ausdruck, die Kurven zu identifizieren. In Realität sind die

Frequenzen stufenlos einstellbar.)

Permanentspeicher

Der Pufferspeicher entspricht der Filmrolle bei

traditionellen (Film-) Kameras. Seine beschränkte Kapazität

erzwingt die Daten in einen Massenspeicher zu verschieben. Man

nützt hier gerne die Festplatte des Steuerrechners und sein

optisches oder Wechsellaufwerk und natürlich das Netzwerk und

die Cloud.

Manche Hochgeschwindigkeitskameras verfügen über eine Festplatte

oder eine Flash-Karte im Kamerakopf. Bei Anwendungen, die eine hohe

mechanische Belastung mit sich bringen (z.B. Einsatz im

Crashfahrzeug, birgt zumindest die Festplatte, auch wenn sie

während des Versuchs automatisch geparkt wird, allerdings ein

gewisses Restrisiko. Selbst wenn verschiedene Modelle für die im

Crashtest üblichen Belastungen spezifiziert sind - falls

geparkt, wohlgemerkt.

Diese Massenspeicher im Kamerakopf können den Arbeitsverlauf

allerdings wesentlich beschleunigen. Man macht in rascher Folge

seine Versuche, schiebt die Daten auf den eingebauten

Massenspeicher und während einer Arbeitspause oder über Nacht lädt

man die Bilddaten herunter oder tauscht den Datenträger einfach

aus.

Visualisierung und Archivierung

Die Bilddaten der Kamera werden abhängig von der

Philosophie des jeweiligen Herstellers mehr oder weniger stark

geschönt ausgegeben. Beispielsweise mit Kontrastspreizung oder

Kantenverstärkung. Die Profis bevorzugen, wie in der Fotografie

auch, den Zugriff auf die RAW-Bilder. Sie sind nicht verfälscht

und sehr effizient. Unkomprimierte AVI-Dateien sind z.B. etwa um

Faktor 3,5 bis 4 größer als RAW-Dateien.

Zunächst sieht man die (potenziellen) Bilddaten über verschiedene

Vorschau- oder Sucher (engl.: viewfinder) Kanäle, die eventuell von

DSPs (Digital Signal Processor) in Echtzeit aufbereitet oder auch

komprimiert worden sind. Oft werden einfache Schärfefilter,

Kantenverstärker und Farbsättigungsfilter eingesetzt. Ganz zu

schweigen von der Fehlpixelkorrektur, d.h. der Interpolation

defekter Pixel durch ihre Nachbarn.

Für eine massive Bildverarbeitung in Echtzeit kann man Software

kaum nutzen. Sie bearbeitet normalerweise erst die im

Massenspeicher abgelegten Daten und wandelt sie in gängige

Dateiformate. Wegen des Rechenaufwands auch schon einmal über

Nacht.

Bei Stichprobentests in der Serienfertigung sicherheitsrelevanter

Geräte werden die Bilddaten auf dauerhaften Datenträgern

gespeichert und archiviert. Bei Airbags z.B. zehn Jahre im Rahmen

des Produkthaftungsgesetzes und weitere drei Jahre, um die

juristische Einspruchsfrist abzudecken. Insgesamt also dreizehn

Jahre. Da kommt dann einiges zusammen.